すべてのクライムアクション映画を置き去りにするサイバー犯罪が現実に起こっています。詳細は以下から。

アラブ首長国連邦のとある銀行の支配人は、長年の付き合いで話したこともある、会社を経営する顧客から電話を受けました。

顧客は自分の会社が重要な買収を行うとして、銀行に3500万ドル(約40億円)相当の資金移動を可能な限り早く許可してほしいと興奮した様子で話しました。

その顧客はMartin Zelner弁護士が買収の契約を動かしているとし、支配人もその弁護士からのメールを確認。支配人は顧客の声を覚えており、話の確認も取れたため、資金移動を承認しました。

その結果、支配人はキャリアに最大の汚点を残すことになりました。すべてが滞りなく済んだと思われた時、すでに巧妙なサイバー犯罪の罠に落ちていたのです。

支配人が電話で話した相手はAIを用いた「ディープフェイク音声」技術を使い、誰にも分からないほどそっくりに顧客の声をまねていました。

その後の調べで、この40億円の一部がCentennial Bankのアメリカに拠点を持つ口座に送金されていたことが判明。

ですが犯人グループには最低でも17人が絡んでいたこと、そして送金先口座は世界中に散らばっており、追跡や回復が困難なこと以上の詳細をつかめていないことをアラブ首長国連邦が認めています。

ディープフェイク音声を使ったと認められる犯罪はこれが世界で2例目とのことですが、サイバー犯罪の専門家はこれは始まりに過ぎないと警告します。ディープフェイクの映像や音声の発展は極めて速く、対策が追いつけなくなるだろうとのこと。

特にディープフェイク音声は映像に比べて作成する難易度が低いため、SNSやYouTubeの動画や、電話での応対からも「声を盗まれる」可能性があるとのこと。

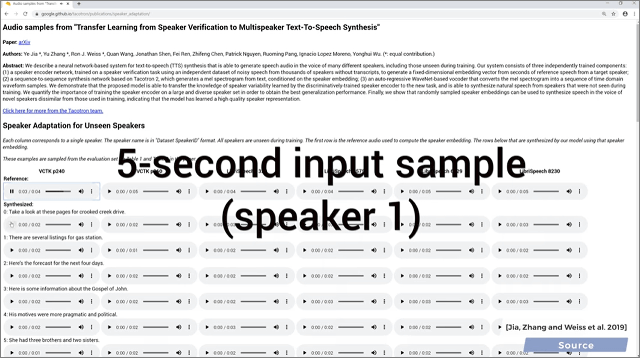

こちらの動画ではわずか5秒ほどの声からAIがそっくりなディープフェイク音声を作れるとしています。

This AI Clones Your Voice After Listening for 5 Seconds 🤐 - YouTube

現在日本では振り込め詐欺などの電話を用いた詐欺が横行していますが、実際に振り込まずに応対しただけでも犯罪に巻き込まれる危険も出てくることになります。

先日もKDDIが自分そっくりの声を少ないデータで再現できる「高効率声質再現音声合成技術」を開発したように、決してこれは遠い未来の技術ではないことは覚えておいた方がよさそうです。

・関連記事

岸田首相からの「投票のお願い」自動音声電話、全国各地で観測される | Your News Online

【追記】「Dappi」回線契約企業の社長、自民党本部の事務方トップ親戚と報道 | Your News Online

GoogleとYouTubeが「気候変動・温暖化否定」広告と収益化を禁止に、違反サイトや動画は広告BANも | Your News Online